搜索引擎Spider的工作原理(深入了解搜索引擎怎样找到并索引网站)

![]() 游客

2023-11-20 17:45:02

291

游客

2023-11-20 17:45:02

291

在日常使用搜索引擎的过程中,我们会发现搜索引擎会自动帮助我们找到相关的网站。这些搜索引擎如何实现这一功能?其实是由搜索引擎Spider完成的。本文将深入探讨Spider的工作原理。

一:爬虫的定义及工作原理

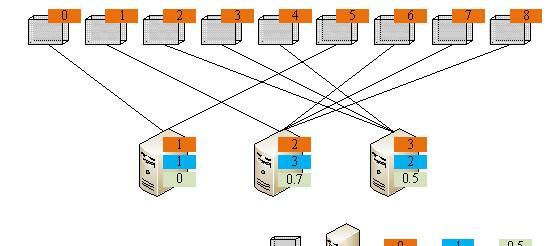

Spider也被称为网络爬虫,它的工作原理是通过互联网上的链接,自动地发现并下载网页。当Spider进入一个网站时,它会从一个起点开始,沿着链接不断地向外发散,直至覆盖整个网站为止。

二:Spider的种类及其特点

Spider主要分为两种:广度优先Spider和深度优先Spider。广度优先Spider以某个固定的起点为出发点,不断扩散它所能发现的链接;而深度优先Spider则会尽可能地深入到一个网站内部,查找更多的链接。

三:Spider的数据结构

Spider的数据结构一般包括URL管理器、下载器、解析器和存储器等。其中URL管理器主要负责管理待访问的URL列表,下载器负责下载网页,解析器负责解析网页信息,存储器负责将爬取的数据保存在数据库或文件中。

四:Spider的常用技术

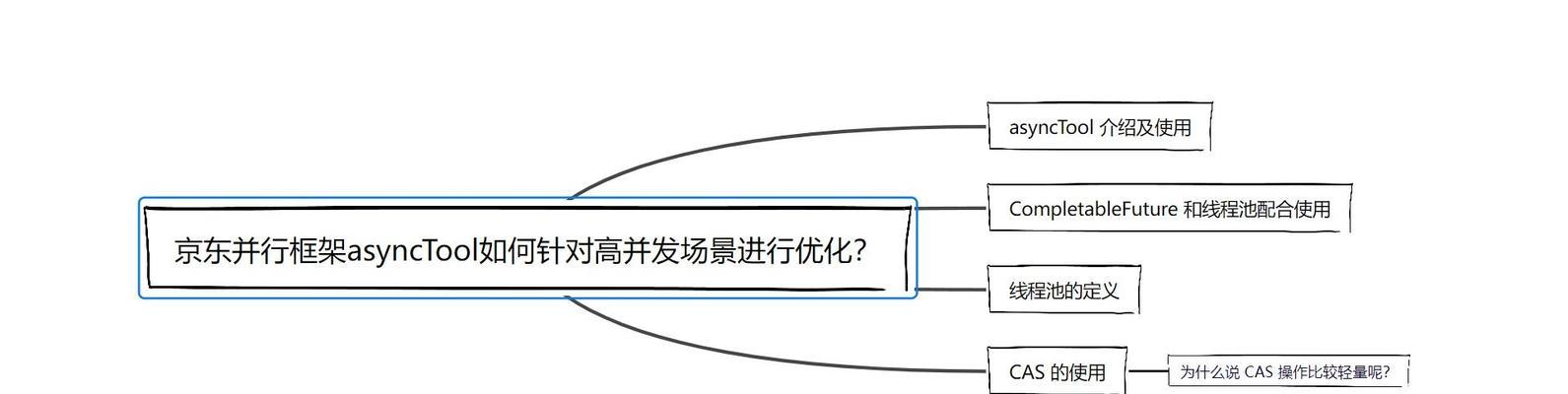

Spider常用的技术包括多线程技术、代理IP技术、反爬虫机制和解析技术等。多线程技术可以提高爬取速度,而代理IP技术可以避免被封禁。反爬虫机制是对抗爬虫行为的措施,解析技术则是对已经爬取到的信息进行分析和处理。

五:Robots协议

Robots协议是一个用来告诉爬虫哪些页面可以被访问的协议。该协议可以在网站根目录下的robots.txt文件中设置。有些网站会设置禁止爬虫访问的页面,这是为了防止搜索引擎过度索引或误导搜索结果。

六:去重算法

在爬取网页时,经常会遇到重复访问同一网页的情况。为了避免浪费时间和资源,Spider需要使用去重算法。常见的去重算法包括哈希算法和BloomFilter算法等。

七:爬虫的优化方法

在实际应用中,由于互联网信息太过于庞杂,单个Spider难以完成全部任务。因此需要对爬虫进行优化。其中包括合理设置请求头、优化解析器、使用多线程等方法。

八:爬虫对SEO优化的影响

在SEO优化中,Spider是一个至关重要的角色。搜索引擎会根据爬虫抓取到的信息进行排名,因此合理运用SEO技术可以提高网站排名。

九:爬虫安全性问题

爬虫可能存在某些安全性问题,如SQL注入、XSS攻击等问题。为了防止这些安全问题的发生,应该使用合法的代码规范和代码检测工具。

十:未来发展趋势

未来爬虫可能会向着更加智能、自动化和分布式方向发展。同时,人工智能和大数据技术也将得到广泛应用。

本文介绍了Spider的工作原理以及相关技术与算法,并对其对SEO优化的影响进行了分析。未来随着人工智能和大数据技术的发展,爬虫也将逐渐走向智能化和自动化。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《搜索引擎Spider的工作原理(深入了解搜索引擎怎样找到并索引网站)》

标签:深圳SEO

- 搜索

- 最新文章

- 热门文章

-

- 全新战力系统来袭,排位或成单排玩家噩梦,百段分路人人皆有可能

- vivo X300Pro曝光:天玑9500+大直屏+2亿潜望,或9月发布!

- 华为Mate 80系列将带来定制OLED显示技术,这项技术具备三大优势

- 抖音中怎么开始剪辑作品?新手入门剪辑流程是什么?

- 抖音视频拍摄与剪辑技巧?如何制作火爆内容?

- 自媒体优化标题怎么做?有效提升文章曝光率的秘诀是什么?

- 产品如何在淘宝推广网站?有哪些有效的推广策略?

- 小吃店抖音视频剪辑技巧有哪些?如何快速上手?

- 如何算卦网站推广赚钱多?有哪些有效策略可以提高收益?

- 华为重磅双旗舰曝光:三折叠MateXT2或9月发布

- 高温红色警报!电动车夏季充电紧急提醒,牢记“3要拔4不充”要求

- 原神:10抽奖励记得领!伊涅芙v3改动!6.0新角色剪影!UGC界面!

- 抖音歌曲片段剪辑技巧?如何快速制作音乐视频?

- 70%的免伤,48%的吸血,孙权成为S40发育路玩家救星!附玩法思路

- 巨大升级?苹果电池干到5000mAh了,续航反杀安卓,库克终于开窍了?

- 抖音视频编辑技巧:如何剪辑掉不美好的部分?

- 抖音漫画视频剪辑技巧有哪些?如何制作高质量内容?

- iQOO15细节曝光:2K大直屏+3D超声波+7K新电池,或10月发布

- 抖音小说视频剪辑技巧有哪些?如何快速制作?

- 抖音自带的剪辑功能如何剪辑片段?操作步骤是什么?

- 热门tag