网站优化之robotstxt文件的设置原理与方法(掌握robotstxt文件)

![]() 游客

2024-06-03 17:30:01

176

游客

2024-06-03 17:30:01

176

在进行网站优化的过程中,robotstxt文件的设置对于SEO排名以及搜索引擎爬行很有影响。本文将介绍robotstxt文件的设置原理与方法,帮助网站管理员更好地掌握这一技术。

一、什么是robotstxt文件?

介绍robotstxt文件是什么。

二、robotstxt文件的作用是什么?

详细介绍robotstxt文件在网站优化中的作用,包括控制搜索引擎爬虫访问哪些页面等。

三、robotstxt文件的格式要求是什么?

介绍robotstxt文件格式的要求,包括文件命名、代码规范等。

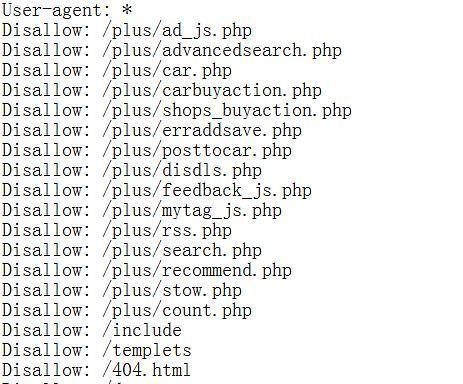

四、robotstxt文件的基本指令有哪些?

详细介绍robotstxt文件中的基本指令,如User-agent、Disallow、Allow等。

五、如何设置robotstxt文件来控制搜索引擎爬虫?

通过示例,详细讲解如何设置robotstxt文件来实现控制搜索引擎爬虫,如阻止某些页面被搜索引擎索引。

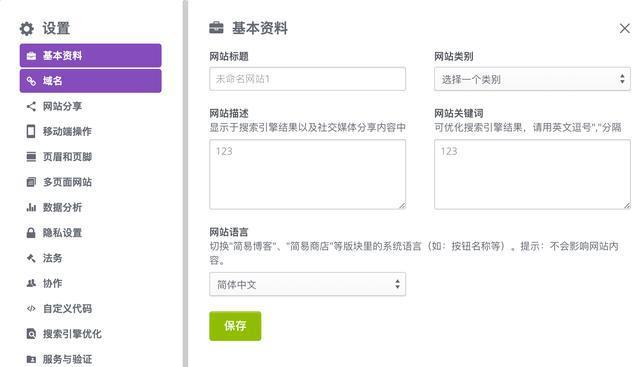

六、如何设置robotstxt文件来优化SEO?

通过示例,讲解如何利用robotstxt文件来优化SEO,如在搜索结果中隐藏某些页面。

七、如何避免robotstxt文件设置不当引起的影响?

介绍如何避免robotstxt文件设置不当引起的负面影响,如误禁止了重要页面等。

八、如何排查robotstxt文件设置的问题?

介绍排查robotstxt文件设置问题的方法,如利用GoogleSearchConsole等工具。

九、robotstxt文件对于不同搜索引擎的适用情况有哪些区别?

介绍robotstxt文件对于不同搜索引擎的适用情况有哪些区别,如Google和Baidu等。

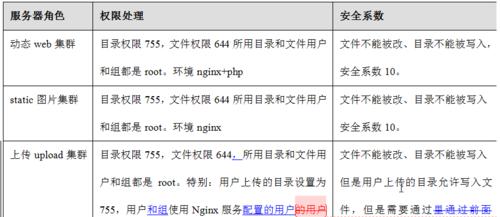

十、robotstxt文件设置需要注意哪些安全问题?

介绍设置robotstxt文件时需要注意的安全问题,如避免设置恶意内容等。

十一、robotstxt文件设置的注意事项有哪些?

详细介绍robotstxt文件设置的注意事项,包括准确理解指令含义等。

十二、如何检测robotstxt文件是否生效?

介绍如何检测robotstxt文件是否生效,如通过搜索引擎爬虫工具等。

十三、如何根据网站特点来灵活设置robotstxt文件?

通过案例讲解如何根据网站特点来灵活设置robotstxt文件,如有多语言页面的网站等。

十四、robotstxt文件对于网站运营和管理有哪些意义?

介绍robotstxt文件对于网站运营和管理的重要意义,包括提升用户体验、优化搜索引擎爬取等。

十五、

本文介绍的内容,强调robotstxt文件对于网站优化的重要性,鼓励网站管理员积极利用这一技术来提升网站的SEO排名和用户体验。

网站优化之robotstxt的原理与设置

在网站优化的过程中,我们常听到robotstxt这个词。什么是robotstxt协议?它又有什么作用?如何设置robotstxt协议?本文将为您详细介绍。

一、什么是robotstxt协议?

Robotstxt协议是指一种被用来告诉搜索引擎哪些页面可以被抓取,哪些页面不可以被抓取的协议。这个协议是通过在网站根目录下放置一个名为“robots.txt”的文件来实现的。需要注意的是,该协议只适用于遵守该协议的搜索引擎。

二、robotstxt协议的作用

robotstxt协议可以让搜索引擎更加高效地抓取网站内容,避免被爬虫非法抓取敏感信息。同时,该协议也可以控制搜索引擎中哪些页面可以展示在搜索结果中,从而达到一定的SEO效果。

三、如何设置robotstxt协议

1.在网站根目录下创建一个名为“robots.txt”的文件。

2.在该文件中,编写需要禁止搜索引擎爬取的页面,格式如下:

User-agent:*

Disallow:/cgi-bin/

Disallow:/tmp/

Disallow:/junk/

“User-agent”为指定的爬虫,"*"为匹配所有爬虫,"Disallow"为禁止的页面。

3.如果需要允许某些页面被搜索引擎抓取,可以使用“Allow”命令进行设置。例如:

User-agent:*

Disallow:/cgi-bin/

Allow:/public/

四、robotstxt协议设置的注意事项

1.尽量不要将重要页面设置为Disallow。

2.遵循robotstxt协议,但不保证禁止所有搜索引擎的抓取。

3.该协议只适用于遵守该协议的搜索引擎。

4.请注意robots.txt文件的编码格式,以免出现乱码等问题。

五、如何检测robotstxt协议设置是否正确

可以通过搜索引擎自带的robots.txt检测工具进行检测,或者在搜索引擎中搜索“site:域名/robots.txt”查看。

六、robotstxt协议的语法规则

1.通配符"*"表示任意字符。

2.斜杠"/"表示目录分隔符。

3.以"$"结束表示匹配路径结尾。

七、如何处理异常状态码

当robots.txt文件返回异常状态码时,应及时排查问题并进行修复。常见的异常状态码包括404、503等。

八、如何处理动态网页的robotstxt

对于动态网页,可以通过服务器端脚本动态生成robots.txt文件,从而实现动态控制搜索引擎抓取的页面。

九、如何处理多个爬虫的robotstxt

可以通过设置多个User-agent来分别控制不同的爬虫抓取网站的页面。

十、如何处理子域名的robotstxt

如果网站有多个子域名,可以在每个子域名下单独设置robotstxt文件,从而实现对不同子域名的控制。

十一、如何应对搜索引擎变化

由于搜索引擎算法的更新,可能会对robotstxt协议产生影响,因此需要及时跟进搜索引擎变化并及时调整robotstxt协议。

十二、如何应对不同语言的网站

对于多语言网站,可以在每个语言的根目录下单独设置robotstxt文件,从而实现对不同语言页面的控制。

十三、如何应对临时关闭网站

如果需要临时关闭网站,可以在robots.txt中设置Disallow:/或者使用503状态码来告知搜索引擎暂时关闭。

十四、如何应对非常规页面

对于非常规页面(如PDF、图片等),可以通过设置Allow命令来允许搜索引擎进行抓取。

十五、

robotstxt协议是网站优化的重要一环,通过合理设置可以提高网站的SEO效果。在优化网站过程中,要对robotstxt协议有一定的了解,做好合理的设置和维护。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《网站优化之robotstxt文件的设置原理与方法(掌握robotstxt文件)》

标签:文件

- 搜索

- 最新文章

-

- 荣耀手机选购指南,三款有明显优势,其中一款续航霸榜!

- 二手苹果手机中最值得购买的3款,个个都拥有很难拒绝的优势!

- 被低估的真香中端旗舰,天玑9400+120W闪充,性价比已反超红米

- iQOO豁出去,2999元的骁龙8至尊版旗舰,2K屏+120W闪充+IP69防水

- 华为新机官宣:7月30日,全面开售

- OPPOK13Turbo值得入手吗?优缺点全面分析,一文看懂!

- 华为Mate80最快或10月发布,屏幕/影像/续航进一步曝光

- 河北!中雨转大雨!局部暴雨!降雨的范围还在扩大增强!具体分布

- 新一轮降雨确定完成,主要分布如下地区,今天夜间~20日天气预报

- 新一轮降雨全面来袭,具体分布如下,6号台风直扑粤琼沿海

- 热门文章

-

- 三星收购人工智能公司Viv,创始人曾建立Siri

- 【二十四节气·小暑】蝉鸣荷风迎暑热-今日头条

- 不止大电池和长焦镜头!红米K90迎来大变,感觉手里的K80不香了

- LPL离谱赛程引争议!全神班争夺沙特杯热度?圣枪哥恐将再次遭重

- 中国手机市场再次洗牌:苹果第五,小米第四,第一名有点小意外

- 网页响应式设计什么意思?如何优化网站响应式体验?

- 如何推广分享网站?有效策略和常见问题解答?

- 各大网站如何推广的软件?推广软件的常见问题有哪些?

- HTML常见标签功能有哪些?如何正确使用它们?

- 企业网站如何推广?有哪些有效的推广策略?

- 潜望长焦回归!iQOO 15系列曝光,Ultra机型成为亮点

- 网站建设分析怎么写简历?简历中应包含哪些关键元素?

- 网站怎么改关键词?改关键词的正确步骤是什么?

- 2亿像素主摄+中底潜望!vivo X300堆料拉满,小米16瑟瑟发抖?

- 网站环境需求分析怎么写?需要考虑哪些关键因素?

- 网站营销软件推荐怎么写?如何选择适合的营销工具?

- 想买电动车的可以笑了!2025下半年换电动车,车主在这3方面受益

- HTML内置对象有哪些?它们的用途是什么?

- 招聘网站薪资架构怎么写?如何吸引求职者?

- 网站内容如何优化推广?有哪些有效的方法和技巧?

- 热门tag