如何防止AI爬虫拖垮网站?

![]() 游客

2025-04-19 15:45:01

107

游客

2025-04-19 15:45:01

107

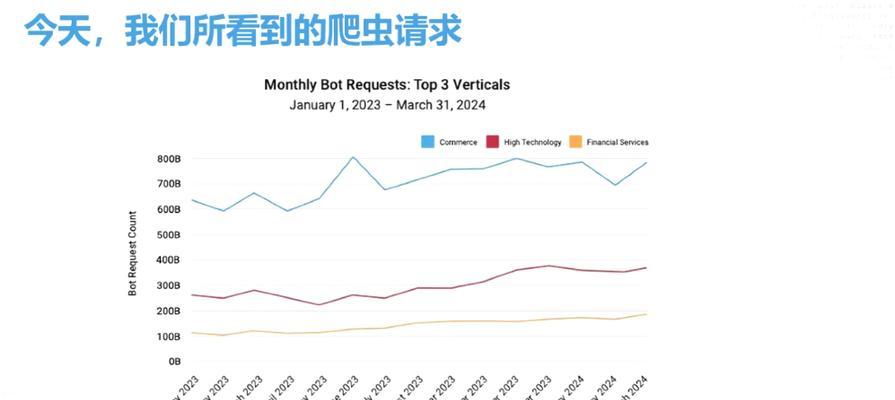

随着人工智能技术的不断进步,AI爬虫的运用愈发广泛,从搜索引擎抓取数据到网络数据监控等场景都离不开爬虫技术。但同时,不恰当的爬虫行为会对网站造成巨大压力,甚至可能导致服务器崩溃。网站管理者应如何采取措施,有效防止AI爬虫拖垮网站呢?本文将提供一系列实用策略和方法,帮助您保护网站资源,确保网站运行稳定。

1.理解爬虫行为及网站面临的挑战

在防爬策略实施之前,首先要了解爬虫的行为模式及其给网站带来的挑战。爬虫主要通过模拟浏览器访问网页,快速获取页面信息。如果爬虫对网站访问过于频繁,会消耗大量服务器资源,导致网站响应速度下降,严重时会使得合法用户无法正常访问网站内容。

2.使用robots.txt文件规范爬虫行为

robots.txt是网站和爬虫之间的“约定俗成”的协议,它位于网站的根目录下。通过编写robots.txt文件,可以明确告诉爬虫哪些页面可以爬取,哪些页面需要限制。例如:

```

User-agent:*

Disallow:/admin/

Disallow:/search/

```

上面的示例代码表示禁止所有爬虫访问网站的“admin”目录和“search”功能。

3.设置合理的爬取频率限制

设置爬虫访问频率限制是防止爬虫过度使用服务器资源的有效措施。对于Python的Scrapy框架,可以在`settings.py`文件中设置下载延迟:

```python

DOWNLOAD_DELAY=1

```

这意味着爬虫在每次请求之间会等待1秒钟。对于其他爬虫框架,也有类似的功能可以实现。

4.动态识别和屏蔽爬虫

对于伪装成正常用户访问网站的爬虫,可以利用行为分析技术进行识别和屏蔽。爬虫访问页面的速度通常比人类快得多,页面停留时间短,可以设置一个阈值,当用户行为符合爬虫特征时,进行二次验证或直接屏蔽IP地址。

5.采用验证码等技术手段防止爬虫

在一些关键操作如注册、登录或提交表单页面,可以设置验证码系统,以区分人类用户和爬虫程序。验证码可以有效阻碍自动化脚本的攻击,提高网站的安全性。

6.使用防火墙对爬虫请求进行控制

现代的Web应用防火墙(WAF)通常具备对爬虫请求的监控和控制功能。通过配置WAF规则,可以限制爬虫对网站的访问频率,甚至拦截恶意爬虫请求。

7.优化服务器资源分配

除了直接针对爬虫的策略之外,优化网站本身也能缓解爬虫带来的压力。通过负载均衡分散访问压力,增加服务器带宽,优化网页和资源加载速度等。

8.监控和日志分析

对网站的访问日志进行分析,监控爬虫的访问模式和IP地址。当发现可疑爬虫行为时,及时调整策略应对。同时,可以利用日志来评估已有防爬措施的有效性。

9.关注法律法规和道德约束

在实施防爬措施时,应当注意避免违反相关法律法规,例如《中华人民共和国网络安全法》等,保证网站行为合法合规。同时,应当考虑到道德约束,尊重数据使用和版权的规定。

10.教育和引导

对于最终用户,也应当提供适当的教育和引导,比如在注册或使用服务前明确告知相关条款,让用户了解网站数据使用和保护的基本原则。

通过上述方法,网站管理者可以有效减少AI爬虫对网站的负面影响,保证网站稳定运行,同时也能保护数据安全和用户隐私。防爬策略并非一成不变,随着技术的不断发展,需要持续关注和更新防爬措施,以适应新的挑战。

综上所述,防止AI爬虫拖垮网站是一个需要综合考虑多方面因素的问题。通过科学配置和合理使用上述策略,可以为网站提供一个更加安全、稳定的运行环境。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《如何防止AI爬虫拖垮网站?》

标签:

- 上一篇: 现代网站建设的常见做法有哪些?

- 下一篇: 如何开发一个智慧社区内网平台的js+uniapp小程序?

- 搜索

- 最新文章

- 热门文章

-

- iPhone能录音了!iOS18通话录音完整教学+开启条件一次看懂

- 关键词快速优化的方法是什么?如何快速提升网站排名?

- 小红书四个关键词文案怎么写?提升曝光的技巧有哪些?

- 8月1日起,电动车、三轮车有新政策,这6类车禁止上路,车主注意

- 在小红书上应该搜索哪些关键词?如何优化关键词提高搜索排名?

- 网站开发制作过程中如何进行SEO优化?步骤是什么?

- 明确了!3类电动车上路免驾照、免年检,4类车驾照、年检都需要

- 苹果发布iOS26首个公测版:升级指南与注意事项全解析

- 实属罕见,中国首次苹果AppleStore直营店宣布关闭!

- 哪个在线制作简历网站更优秀?如何制作吸引HR的简历?

- 新一轮强降雨范围已定!今天夜间至7月28日天气,暴雨分布如下

- 上海网站关键词优化公司有哪些服务?如何选择合适的关键词优化服务?

- 搜索关键词选择的策略是什么?

- 建设网站时SEO应如何考虑?有哪些SEO最佳实践?

- 网站如何推广的步骤?有哪些有效方法可以提升网站流量?

- 国外的网站如何做推广?有哪些有效的推广策略?

- 选择抖音关键词推广机构的标准是什么?

- 淘宝关键词标准计划如何制定?优化推广效果的步骤是什么?

- 新版本中关键词的查看方法是什么?

- 现在发抖音的关键词是什么?如何跟上热点趋势?

- 热门tag