网站如何收录关键词(网站seo关键词评估)

![]() 三石哥

2022-11-22 12:43:14

190

三石哥

2022-11-22 12:43:14

190

关于文档类型网站的搜索引擎收录优化

关于文档类型网站的搜索引擎收录优化,这也是不少企业关注的话题。小站长刚好帮助过一个客户解决了这个问题,现在就跟大家分享一下如何解决这个问题

1:客户痛点:客户的网站是做标准类型文档的,有几十万的标准文档,可以说资料非常丰富,但是一直很难被搜索引擎收录。所以找到小站长。

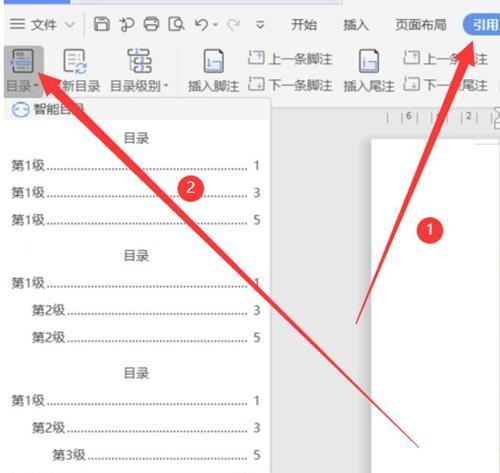

2:分析问题:小编仔细分析了这个网站,发现网站整个架构比较乱,最主要的是全部页面都是用链接的。例如首页里面的链接都是通过js来实现的,这样搜索引擎来到首页的时候,是无法继续往下爬取的。关于网站优化有一个很重要的点,那就是网站尽可能是可以从首页直接究尽所有的页面。这样就可以爬取到所有的页面了。

3:解决问题:找到问题就好办了,因为蜘蛛无法爬取到几十万个页面的数据,所以重新调整了网站的架构,把js改成a标签的形式,同样的把几十万个页面分成了若干个sitemap并提交了搜索引擎站长。

4:效果呈现:经过一个月的处理之后,网站整整提升了1万+的收录页面,而且收录的还度越来越快。很多词也开始有排名了。这样整个网站的权重就会提升了。

总结:在这里小编只是介绍了自己的思路,关于文档类型、标准类型的网站,一定要做好seo的架构,让蜘蛛从一个页面可以爬到所有的页面,否则是很难提升收录的。文档类型的网站是比较容易做起来的,因为资料非常多,这样可以获得非常多的关键词。这种类型的网站的权重是不会低的,一般都是权重6+,还是非常有价值的网站建设哦。

网站SEO优化:快速提升网站页面收录的文件,robots书写规则

我们很多时候感觉网站页面被搜索引擎收录得越多越好,这句话本身没有什么错误,但是我们会发现很多网站页面是我们不需要被收录都被收录了,我们需要搜索引擎收录的页面的反而没有被收录,其实爬虫在爬取我们网站的时间是有限的,怎么样才能在有限的时间爬取我们的更多的页面,我们就要告诉爬虫爬取我们需要它去爬取的内容页面,那么就需要一个robots.txt文本文件。

tobots.txt网站收录协议

什么是robots.txt文件

robots是网站跟爬虫间的协议,用简单直接的txt格式文本方式告诉对应的爬虫被允许的权限,也就是说robots.txt是搜索引擎中访问网站的时候要查看的第一个文件。当一个搜索引擎蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。

robots.txt文件放置的位置

robots.txt文件放在网站根目录下。搜索引擎蜘蛛访问一个站点时,首先检查该站点根目录下是否存在robots.txt文件,如果搜索引擎蜘蛛找到这个文件,它就会根据这个文件的内容,来确定它访问权限的范围。

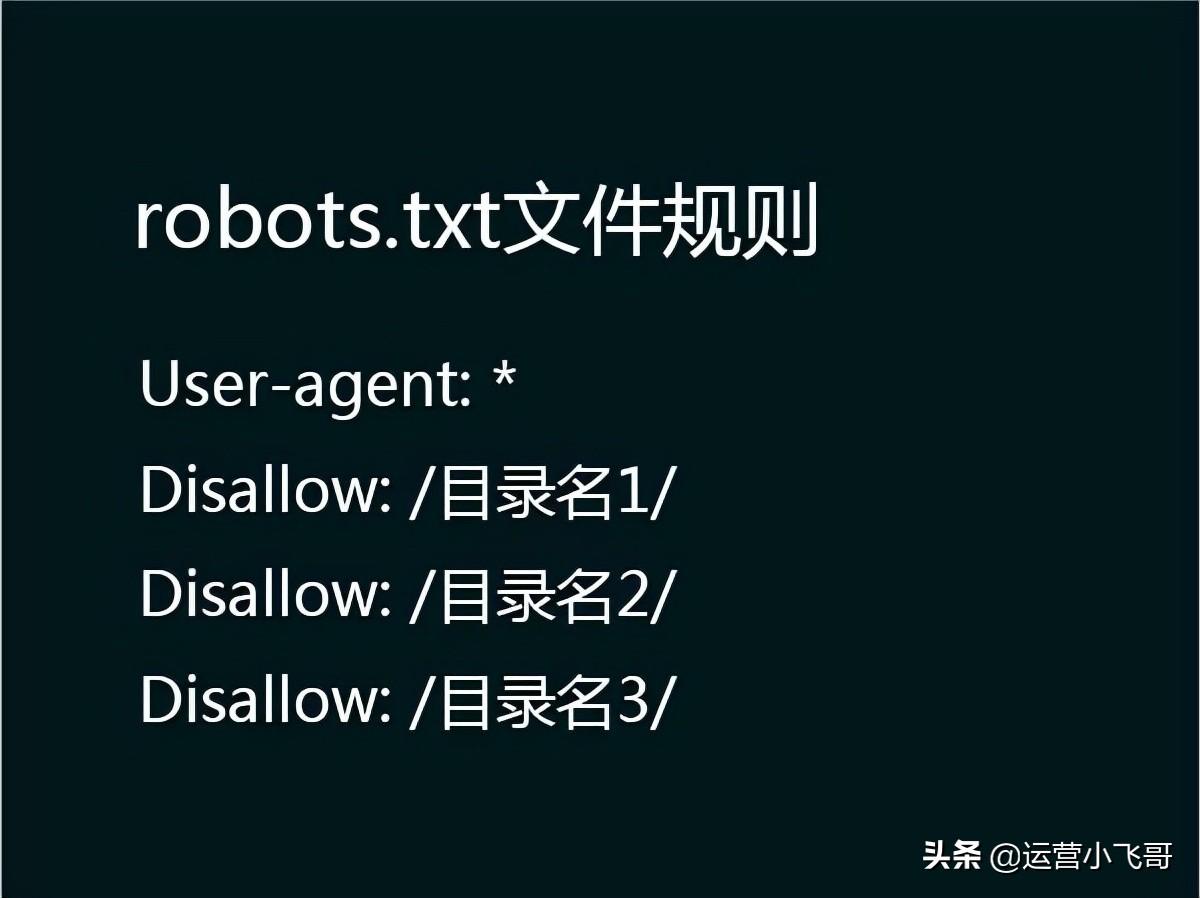

robots.txt文件规则

robots.txt规则

该文件中的记录通常以一行或多行User-agent开始,后面加上若干Disallow行,详细情况如下:

User-agent:

该项的值用于描述搜索引擎robot的名字,在"robots.txt"文件中,如果有多条User-agent记录说明有多个robot会受到该协议的限制,对该文件来说,至少要有一条User-agent记录。如果该项的值设为*,则该协议对任何机器人均有效,在"robots.txt"文件中,"User-agent:*"这样的记录只能有一条。

Disallow:

该项的值用于描述不希望被访问到的一个URL,这个URL可以是一条完整的路径,也可以是部分的,任何以Disallow开头的URL均不会被robot访问到。例如"Disallow:/help"对/help.html 和/help/index.html都不允许搜索引擎访问,而"Disallow:/help/"则允许robot访问/help.html,而不能访问/help/index.html。任何一条Disallow记录为空,说明该网站的所有部分都允许被访问,在"/robots.txt"文件中,至少要有一条Disallow记录。如果"/robots.txt"是一个空文件,则对于所有的搜索引擎robot,该网站都是开放的。

Allow:

该项的值用于描述希望被访问的一组URL,与Disallow项相似,这个值可以是一条完整的路径,也可以是路径的前缀,以Allow项的值开头的URL是允许robot访问的。例如"Allow:/baidu"允许robot访问/baidu.htm、/baiducom.html、/baidu/com.html。一个网站的所有URL默认是Allow的,所以Allow通常与Disallow搭配使用,实现允许访问一部分网页同时禁止访问其它所有URL的功能。

robots.txt语法

1.允许所有搜索引擎收录本站信息:

robots.txt为空就可以,什么都不要写。或者

User-agent: *

Disallow:

2. 禁止所有搜索引擎收录网站的某些目录:

User-agent: *

Disallow: /目录名1/

Disallow: /目录名2/

Disallow: /目录名3/

3. 禁止某个搜索引擎收录本站,比如禁止某度收录:

User-agent: Baiduspider

Disallow: /

4. 禁止所有搜索引擎收录本站信息:

User-agent: *

Disallow: /

robots网站跟爬虫间的协议

robots.txt对于网站SEO优化的作用

搜索引擎通过爬虫spider程序会自动搜集互联网上的网页并获取相关信息。我们通常网站上会有一些内容是不想让蜘蛛抓取的,所以经常会使用robots文件把一些不想被抓取的内容告诉爬虫。

还有就是我们希望搜索引擎爬虫在有限的带宽爬取我们更多更有用的信息,进而让这些页面获取更好的排名。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《网站如何收录关键词(网站seo关键词评估)》

- 上一篇: seo网站页面优化包含(百度竞价关键词质量度)

- 下一篇: 网站运营指标(内容运营的案例)

- 搜索

- 最新文章

-

- 苹果iPhone17Air渲染图曝光,配置基本清晰,优缺点分析一文看懂

- iQOO15细节曝光:2K大直屏+3D超声波+7K新电池,或10月发布

- 70%的免伤,48%的吸血,孙权成为S40发育路玩家救星!附玩法思路

- 王者S40法师玩家遭到重创,貂蝉成首个受害对象,妲己小乔无一幸免

- 借助三星的帮助 OLED MacBook Pro仍有望于2029年推出

- 高温红色警报!电动车夏季充电紧急提醒,牢记“3要拔4不充”要求

- 华为重磅双旗舰曝光:三折叠MateXT2或9月发布

- iPhone 17 Pro新MagSafe设计曝光:圆形底部带开口,系统磁圈布局做了调整

- 三星Galaxy S26 Ultra手机曝料:5000mAh电池、2亿像素主摄

- iPhone又立功!登山者被困雪山使用卫星短信功能成功获救

- 热门文章

-

- 魔兽怀旧服:新饰品测试结果,提升最大职业确定,这些专精可无视

- 7月国补后,可以“闭眼买”的3款直屏手机,怎么选都很香。

- iQOO小屏旗舰曝光:骁龙8E2+6.3x直屏,或明年上半年发布

- 抖音视频剪辑技巧有哪些?如何正确使用抖音视频素材进行编辑?

- 荣耀Power中端新机曝光:8000mAh+无线充+卫星通信,续航大幅提升

- 新 Apple Watch 即将到达,史诗更新,看看有啥大变化?

- 抖音短篇小说剪辑技巧有哪些?如何快速掌握剪辑流程?

- 小米 MIX Flip 2 首发评测:是性能最强小折叠,也是小米拍立得

- 怎么搜索网站关键词的网址?有哪些有效的搜索技巧?

- 抖音视频剪辑功能怎么用?如何快速上手抖音视频编辑?

- 小红书博主怎么剪辑视频?剪辑技巧和常见问题解答?

- 如何在抖音上发布视频时去除剪映水印?

- 微信更新新功能:语音、视频通话支持弹窗接听

- 抖音剪辑层级怎么做?掌握技巧提升视频质量?

- iPhone版微信推出重要新功能视频通话快捷接听,灵动岛通知增强!

- 新赛季更新时间确定,S40强度提升最大的4件装备确定,后羿成No.1

- 无界14X斗战版对荣耀笔记本X16 谁又是更适合咱们的选择呢?

- 抖音爆火剪辑怎么做?掌握这些技巧轻松上热门!

- 抖音剪辑短剧新规怎么弄?新规实施后如何合规操作?

- 小红书视频素材剪辑技巧?如何快速编辑视频内容?

- 热门tag