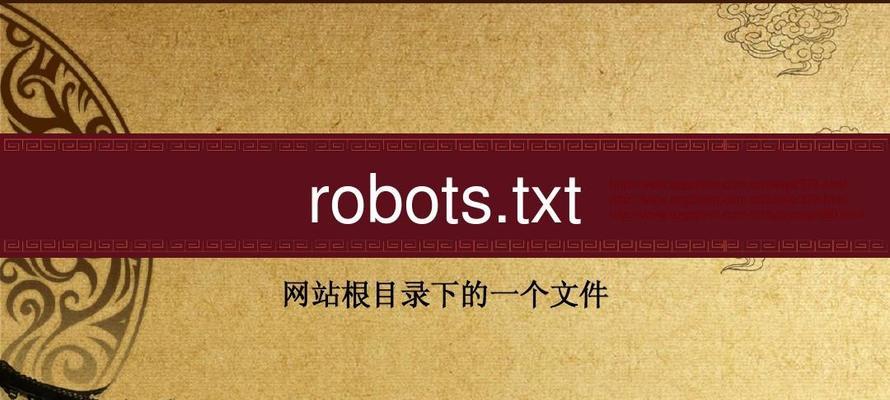

深度解析网站的robots文件(什么是robots文件?为什么需要它?如何编写robots文件?)

![]() 游客

2023-11-17 17:30:02

167

游客

2023-11-17 17:30:02

167

随着互联网的迅猛发展,越来越多的网站涌现出来,如何让搜索引擎更好地理解自己的网站,从而使网站排名更好,成为了每个站长都需要考虑的问题。而这时,我们就需要用到一个神奇的文件,它就是robots文件。

什么是robots文件?

robots文件是一个纯文本文件,用于指导搜索引擎抓取和处理网站中的内容。它可以告诉搜索引擎哪些页面可以抓取,哪些页面不能抓取,以及抓取速度等相关信息。

为什么需要robots文件?

我们需要了解搜索引擎是如何抓取页面的。一般情况下,搜索引擎会从一个页面开始抓取,并从该页面中提取所有的链接,然后再继续抓取这些链接指向的页面。如果一个网站中有很多无用的页面,那么搜索引擎会浪费很多时间和资源去抓取这些页面,从而降低了抓取效率。而通过编写robots文件,我们可以告诉搜索引擎哪些页面可以抓取,哪些页面不需要抓取,从而提高了抓取效率。

如何编写robots文件?

编写robots文件并不是一件很难的事情。我们需要创建一个纯文本文件,并将其命名为robots.txt。我们需要按照一定格式编写robots规则。一个典型的robots规则包括两个部分:User-agent和Disallow。User-agent表示搜索引擎的名称,而Disallow则表示禁止抓取的页面。例如,我们可以编写如下规则:

User-agent:*

Disallow:/admin/

这个规则表示禁止所有搜索引擎抓取网站中的/admin/目录。

如何生效?

一旦我们完成了robots文件的编写,我们就需要将其放置在网站的根目录下。当搜索引擎访问网站时,它会首先尝试访问该文件,并根据该文件中的规则进行相应处理。

robots文件的常用命令

除了Disallow命令之外,robots文件还有一些其他常用的命令。例如:

1.User-agent:该命令可以指定适用于哪些搜索引擎。

2.Allow:该命令可以允许搜索引擎访问被Disallow命令禁止访问的页面。

3.Sitemap:该命令可以指定网站地图的位置。

4.Crawl-delay:该命令可以指定抓取速度。

注意事项

虽然编写robots文件很简单,但是我们还需要注意一些事项。我们需要确保所有被禁止访问的页面都是真正无用的页面。如果一个重要页面被禁止访问,那么搜索引擎就无法正确抓取该页面,从而降低了网站的排名。此外,在编写Crawl-delay命令时,我们需要注意不要设置太长时间的等待时间,否则会导致搜索引擎无法顺利抓取页面。

robots文件与SEO

搜索引擎优化(SEO)是指通过优化网站内容和结构等方式提高网站在搜索引擎中的排名。而robots文件正是SEO中非常重要的一部分。通过编写合理的robots文件,我们可以让搜索引擎更好地理解网站内容和结构,从而提高网站在搜索引擎中的排名。

robots.txt和sitemap.xml有何区别?

除了robots.txt之外,还有一个非常重要的文件就是sitemap.xml。它可以帮助搜索引擎更好地理解网站结构和内容,并加速爬取速度。相比之下,robots.txt更注重告诉搜索引擎哪些页面可以访问和哪些页面不可以访问。

如何查看网站是否有robots文件?

如果想查看一个网站是否有robots文件,只需要在网站域名后加上/robots.txt即可。例如:

http://www.example.com/robots.txt

如果该网站存在robots文件,则会直接显示其内容。如果不存在,则会显示404错误。

通过本文的介绍,我们了解了什么是robots文件以及为什么需要它。同时,我们还学习了如何编写和生效robots文件,并介绍了其常用命令和注意事项。我们还了解了robots.txt和sitemap.xml之间的区别。希望本文对大家学习和了解网站优化有所帮助。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《深度解析网站的robots文件(什么是robots文件?为什么需要它?如何编写robots文件?)》

标签:文件

- 搜索

- 最新文章

-

- 老年人可以笑了!这4种电动车上路,不罚不扣,不查不禁,放心骑

- 《哪吒2》生不逢时,全球年冠和影史第五保不住了

- 16GB+1TB!新机官宣:搭载骁龙8Elite2+2亿潜望长焦!

- 8000大电池+2K直屏!最便宜的骁龙8至尊2代新机要秒小米16?

- 联想小新Pro14GT酷睿Ultra5225H与锐龙A7H350版对比,哪款值得买

- iPhone16Pro性价比降低,最值得购买的苹果手机已经"易主"了!

- 24天卖出100万台,7550mAh+IP69防水,8月可“闭眼买”的千元机

- 安兔兔次旗舰性能榜更新:OPPOReno14仅排第七,第一名意料之中

- 山东台风雨跑偏!分析:4日起新一轮更大范围降雨来袭,警惕强对流

- 新一轮强降雨范围已定!今天夜间至8月4日天气,大雨暴雨分布如下

- 热门文章

-

- 鸿蒙版微信安装破1000万,26天增加300万,生态进入良性循环

- 8月起,电动车、三轮、四轮车上路“5必查”新规!违者处罚明确

- 不禁、不罚、不扣!三、四轮车又有新情况,上牌、上路都有好消息

- 新一轮强降雨范围已定!今天夜间至7月29日天气,暴雨分布如下

- Canalys发报告:华为第一,苹果第五

- 世界大运会收官!金牌榜对比:美国28枚,日本34枚,中国令人意外

- 《731》撤档,300多万观众白等了,《南京照相馆》的冠军稳了

- 6.9寸超大LCD屏+高通强U+7000大电池!这小米百元新机是真想买

- 首发顶级旗舰U+8000毫安大电池!这款性价比新机又要卖爆?

- 河北!大范围降雨来到!中雨、大雨、暴雨!具体分布在如下!

- 微信支付接入鸿蒙操作系统收银台,支付更便捷

- 国补后可“闭眼买”的千元机,跑分240万+7550mAH,金属中框+IP69

- 从搜索引擎优化的角度来看?SEO文章标题如何编写更有效?

- 还在被iPhone小红点烦到崩溃?三步教你彻底关闭它,亲测有效!

- 抖音SEO营销获客工具都有哪些?如何有效使用它们进行客户获取?

- 新一轮台风雨范围已定!今天夜间至7月30日天气,暴雨分布如下

- 武大诬告案反转,男生人生被毁,女生嚣张放狠话,还炫耀保研成功

- 告别第三方PDF!iOS26预览App17招超实用技巧学生、上班族适用

- 3600元!育儿补贴正式公布两个条件是关键2024年出生能拿多少?

- 1399元!荣耀首销“十连冠”,8300mAh+IP69K防水

- 热门tag