搜索引擎爬行问题如何解决?常见爬虫错误有哪些?

![]() 游客

2025-08-01 11:45:02

8

游客

2025-08-01 11:45:02

8

搜索引擎爬行问题:如何避免被爬虫拒绝访问?

随着互联网的发展,搜索引擎已经成为人们获取信息的重要途径。而搜索引擎的爬虫技术则是实现这一功能的关键。然而,很多网站经常遇到被爬虫拒绝访问的问题,这不仅会影响网站的排名,也会影响用户的体验。该如何避免这个问题呢?

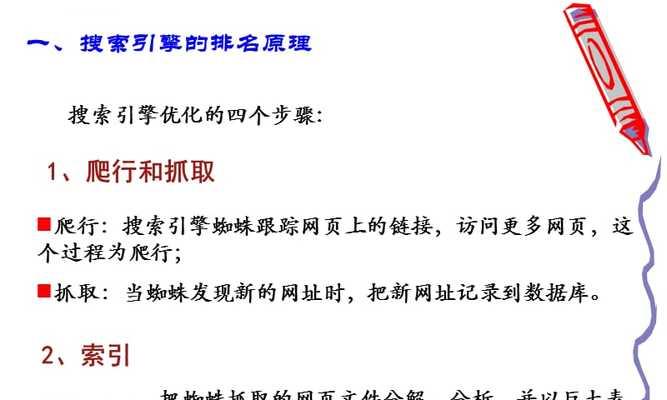

一、什么是搜索引擎爬行?

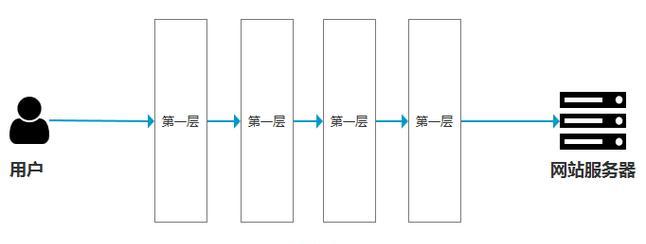

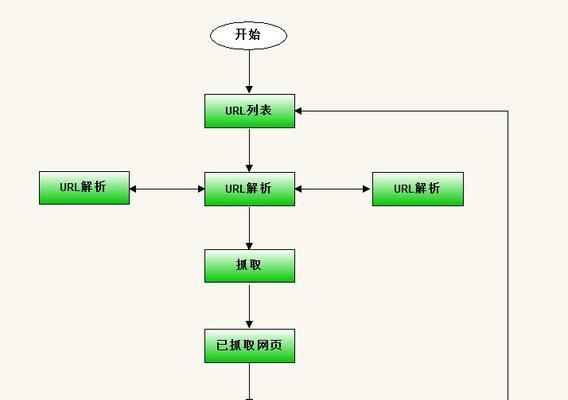

搜索引擎爬行是指搜索引擎通过爬虫程序,自动访问网站并采集网站内容的过程。搜索引擎爬虫会按照一定的规则依次访问网站的每一个页面,并将页面内容存储在搜索引擎的数据库中。

二、为什么会被爬虫拒绝访问?

1.网站结构问题:如果网站结构不够清晰,爬虫程序就很难找到需要访问的页面。

2.网站速度问题:如果网站响应速度过慢,爬虫程序可能会因为等待时间过长而放弃访问。

3.反爬虫策略:为了防止恶意爬虫的访问,很多网站会采取反爬虫策略,例如IP封禁、验证码等。

三、如何避免被爬虫拒绝访问?

1.建立网站地图:建立网站地图可以帮助爬虫程序更快地找到需要访问的页面。

2.优化网站速度:优化网站速度可以提升用户体验,同时也有助于爬虫程序的访问。

3.设置robots.txt:通过设置robots.txt文件,可以告诉爬虫程序哪些页面可以被访问,哪些页面不可以被访问。

4.遵守搜索引擎规则:遵守搜索引擎的规则可以增加网站的可信度,从而避免被搜索引擎惩罚。

5.减少反爬虫策略:反爬虫策略会增加爬虫程序的访问难度,但过多的反爬虫策略会影响用户体验,应该适量使用。

四、如何识别恶意爬虫?

1.检查User-Agent:恶意爬虫往往会伪装成正常的浏览器访问网站,但是它们的User-Agent信息可能有所不同。

2.分析访问频率:恶意爬虫往往会通过大量访问来采集网站内容,因此可以通过分析访问频率来识别它们。

3.检查来源IP地址:可以通过检查来源IP地址来判断是否是恶意爬虫。

五、

搜索引擎爬行问题不仅会影响网站的排名,也会影响用户的体验。网站管理员应该积极采取措施来避免被爬虫拒绝访问。同时,应该注意识别恶意爬虫,保障网站的安全。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《搜索引擎爬行问题如何解决?常见爬虫错误有哪些?》

标签:搜索引擎

- 搜索

- 最新文章

- 热门文章

-

- 小红书四个关键词文案怎么写?提升曝光的技巧有哪些?

- 网站开发制作过程中如何进行SEO优化?步骤是什么?

- 实属罕见,中国首次苹果AppleStore直营店宣布关闭!

- 搜索关键词选择的策略是什么?

- 新一轮强降雨范围已定!今天夜间至7月28日天气,暴雨分布如下

- 鸿蒙版微信安装破1000万,26天增加300万,生态进入良性循环

- 不禁、不罚、不扣!三、四轮车又有新情况,上牌、上路都有好消息

- 8月起,电动车、三轮、四轮车上路“5必查”新规!违者处罚明确

- 选择抖音关键词推广机构的标准是什么?

- 抖音屏蔽关键词全攻略:步骤详解

- 如何优化seo搜索?提升网站排名的技巧是什么?

- 新一轮强降雨范围已定!今天夜间至7月29日天气,暴雨分布如下

- 《731》撤档,300多万观众白等了,《南京照相馆》的冠军稳了

- 樊振东澄清与刘国梁关系,暂时不回国乒并说出原因!

- 世界大运会收官!金牌榜对比:美国28枚,日本34枚,中国令人意外

- Canalys发报告:华为第一,苹果第五

- 首发顶级旗舰U+8000毫安大电池!这款性价比新机又要卖爆?

- 网站建设网络2025年哪种内容形式对SEO更有利?未来趋势和建议是什么?

- 6.9寸超大LCD屏+高通强U+7000大电池!这小米百元新机是真想买

- 抖音视频搜索关键词有何作用?

- 热门tag