掌握SEO中robots文件的应用技巧(优化网站流量,提高搜索引擎排名)

![]() 游客

2023-09-19 10:15:04

199

游客

2023-09-19 10:15:04

199

在当今数字化的时代,网站SEO已经成为了企业必须掌握的核心技能之一。而在SEO的过程中,robots文件的应用是不可或缺的一环。本文将从多个角度,深入探讨如何应用robots文件优化网站流量,提高搜索引擎排名。

一、robots文件是什么?

1.1定义

robots文件是一种文本文件,用于指导搜索引擎爬虫对网站的访问行为。通过设置robots文件,网站管理员可以控制搜索引擎爬虫访问网站的频率、深度和范围等。

1.2robots文件的作用

通过设置robots文件,管理员可以防止搜索引擎爬虫访问某些敏感页面,减少不必要的流量消耗,提高网站速度;同时也可以避免搜索引擎爬虫误访问重复页面,影响网站排名。

二、常见的robots指令

2.1noindex指令

noindex指令用于指示搜索引擎不要索引当前页面。通常用于一些敏感页面、测试页面或者重复内容的页面。

2.2nofollow指令

nofollow指令用于告诉搜索引擎不要追踪当前页面上的链接,防止流量被占用或者被外链污染。

2.3disallow指令

disallow指令用于禁止搜索引擎访问指定路径下的页面或文件。通常用于禁止爬虫访问敏感信息或者无关信息。

三、如何编写robots文件

3.1创建robots.txt文本文件

管理员可以使用任何文本编辑器来创建robots.txt文本文件,确保文件名为“robots.txt”。

3.2编写指令

管理员需要根据网站实际情况编写相关指令,确保指令的正确性和完整性。

四、常见的robots文件错误

4.1语法错误

如果robots.txt文本文件存在语法错误,爬虫可能无法正确解析文件,导致无法控制流量。

4.2路径错误

如果指令路径错误,可能会导致爬虫无法访问到想要控制的页面或文件。

五、如何测试robots文件

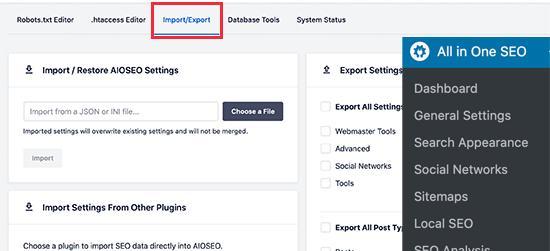

5.1使用GoogleSearchConsole

GoogleSearchConsole提供了功能强大的robots测试工具,可以检测管理员编写的robots是否正确生效。

5.2使用在线测试工具

现有很多在线的robots测试工具,管理员可以利用这些工具快速检测robots文件是否生效。

六、如何优化robots文件

6.1优化sitemap.xml文件

管理员可以在robots中添加sitemap.xml的路径,以便更好地通知爬虫有哪些页面需要索引。

6.2避免重复内容

通过设置noindex指令,避免重复内容被搜索引擎索引,降低网站质量得分。

七、如何应对robots文件变更带来的影响

7.1变更后可能出现的问题

如果管理员对robots文件进行了变更,可能会导致一些页面无法被索引或者无法被访问。

7.2处理变更带来的影响

管理员可以使用GoogleSearchConsole等工具检测变更后的影响,及时采取措施避免流量损失。

八、如何监控robots访问日志

8.1日志记录格式

网站服务器可以记录每个用户请求服务器时所产生的日志。监控日志可以帮助管理员追踪异常访问行为。

8.2监控工具

现有很多工具可以帮助管理员监控日志,例如ELKStack等。

通过对本文内容的阅读,读者可以全面了解并掌握SEO中robots文件的应用技巧。通过合理设置robots指令和优化sitemap.xml等手段,管理员可以提高网站流量质量和排名效果。同时,管理员也需要注意日常监控和处理变更带来的影响,确保网站SEO运作的稳定性和可持续性。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自专注SEO技术,教程,推广 - 8848SEO,本文标题:《掌握SEO中robots文件的应用技巧(优化网站流量,提高搜索引擎排名)》

标签:文件

- 搜索

- 最新文章

- 热门文章

-

- 小红书四个关键词文案怎么写?提升曝光的技巧有哪些?

- 网站开发制作过程中如何进行SEO优化?步骤是什么?

- 实属罕见,中国首次苹果AppleStore直营店宣布关闭!

- 搜索关键词选择的策略是什么?

- 新一轮强降雨范围已定!今天夜间至7月28日天气,暴雨分布如下

- 鸿蒙版微信安装破1000万,26天增加300万,生态进入良性循环

- 不禁、不罚、不扣!三、四轮车又有新情况,上牌、上路都有好消息

- 8月起,电动车、三轮、四轮车上路“5必查”新规!违者处罚明确

- 选择抖音关键词推广机构的标准是什么?

- 抖音屏蔽关键词全攻略:步骤详解

- 如何优化seo搜索?提升网站排名的技巧是什么?

- 新一轮强降雨范围已定!今天夜间至7月29日天气,暴雨分布如下

- 《731》撤档,300多万观众白等了,《南京照相馆》的冠军稳了

- 樊振东澄清与刘国梁关系,暂时不回国乒并说出原因!

- Canalys发报告:华为第一,苹果第五

- 世界大运会收官!金牌榜对比:美国28枚,日本34枚,中国令人意外

- 首发顶级旗舰U+8000毫安大电池!这款性价比新机又要卖爆?

- 网站建设网络2025年哪种内容形式对SEO更有利?未来趋势和建议是什么?

- 6.9寸超大LCD屏+高通强U+7000大电池!这小米百元新机是真想买

- 抖音视频搜索关键词有何作用?

- 热门tag